Los científicos hace muchos años que debatimos sobre un dato, un indicador. Tan simple e ingenioso como fue creado y tantos dolores de cabeza que provoca. Evidentemente, no es otro que el factor de impacto, un dato que en forma simple nos predecía las citas esperadas en promedio por un artículo publicado en una revista científica. Un simple dato, frío, y usado y debatido calurosamente durante casi 40 años .

Ciertamente, la principal premisa asociada era que una cita es un indicio de calidad. El problema ha sido cuántas decisiones se han tomado en función de eso. Inicialmente debía ser para permitir que las bibliotecas pudieran decidir qué revistas compraban. A partir de aquí , ya se trasladó a las comparaciones entre las producciones científicas de personas, grupos de investigación e instituciones. Un escalado que en algunos pocos casos podría haber pervertido el sentido científico y en la mayoría de los casos haber permitido comparar datos no comparables, como ver si los matemáticos eran mejores que los ingenieros agrícolas en función de las citas recibidas. Como demasiadas veces, muy en bruto para poder discriminar con acierto.

También hay que decir que últimamente se ha ponderado el valor del factor de impacto de las revistas y se ha bajado el foco a un escenario más asumible y digerible, como sería el del artículo. Ya no valoramos la revista, porque en el fondo estamos juzgando si el conjunto de los artículos como conjunto tienen tantas citas. Ahora ya somos evaluados por las citas que reciben nuestros artículos. Continuamos pues con la premisa "citación es indicio de calidad".

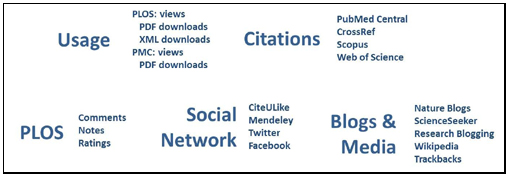

Como era suponible en un universo repleto cada vez de más datos y de herramientas para medirlas, el razonamiento que hay en los defensores de las métricas alternativas es que antes sólo podíamos estudiar un único uso de los artículos. Si eran citados. No podíamos saber cuántas veces eran hojeados, leídos, recomendados, fotocopiados, impresos, etc. Las revistas electrónicas ya permiten todo esto. Los grandes pioneros de ello han sido las revistas de PLOS y algunos servicios que incorporan como son Article Level Metrics. Por lo tanto, ahora un artículo ya podría ser no sólo medible por las citas. El concepto impacto académico puede convertirse en mucho más amplio.

Figura 1. Indicadores que ofrece PLOS a través del Article Level Metrics.

Si nos fijamos, sin embargo, y no es todavía una crítica a las métricas alternativas, en el fondo no hacemos más que describir más datos en torno a una realidad, como es un artículo. Sabremos y conoceremos mucho más por donde habrá fluido el conocimiento científico que ha incorporado. Posiblemente el concepto impacto se bifurcará del concepto calidad. Impacto en palabras mayores. Sabremos cuánta gente lo ha citado, cuánta la ha descargado, cuánta la ha citado por twitter, por decirlo de alguna forma todo su rastro digital, pero esto tampoco nos dirá mejor si un artículo es bueno o no. ¿Y si falla la metodología pero los resultados son muy mediáticos? ¿Y si toca aspectos morales o políticos que lo hacen correr como la pólvora pero que no lo revisten de solidez científica?

Así pues, las medidas alternativas para mí presentan la principal ventaja de que ya no dependemos de un indicador, el que cada año cuando salía se convertía en un juicio para editores científicos, bibliotecarios e investigadores. Pero también plantea algunos puntos oscuros o dudas por resolver. Por ejemplo, como ponderamos entre ellos estos indicadores. A mí me puede servir saber si tiene tantas visiones como mejorar mi forma de explicar o lo que sea, ¿pero cuenta más si ha sido descargado en pdf que no compartido vía Mendeley? ¿Que sea compartido por Twitter dice mucho de mi trabajo o de mi red de contactos? ¿Se pueden crear colegios más que invisibles con redes sociales de citación no ligadas a la calidad de la investigación?

Posiblemente, todo son terrenos nuevos, y habrá que redefinir, por ejemplo, la ética de la presencia de los investigadores en las redes sociales, sean académicas o no. En todo caso, son tiempos de cambios. Nuevos indicadores de evaluación hacen actuar de forma diferente, consciente o no, la forma en que creamos, consumimos y difundimos la información. Son tiempos, pues, para poder construir modelos diferentes de Comunicación Científica. Podemos decir, por fin, que el sistema de información científica, tantos años después de la irrupción de Internet, hará cambiar de nuevo los usos y costumbres de los académicos. Que sea para bien.

Para saber más:

Aranda, D. (2012) “¿ISI lo quemamos todo?”. COMeIN. Revista dels Estudis de Ciències de la Informació i la Comunicació, núm. 17 (desembre).

Lin, J.; Fenner, M. (2013). "Altmetrics in Evolution: Defining and Redefining the Ontology of Article-Level Metrics". Information Standards Quarterly, 25 (2), p. 20.

López-Borrull, A. (2014). "Retos de la comunicación científica". Anuario ThinkEPI, v. 8.

López-Borrull, Alexandre (2013). "Más madera, es la guerra". COMeIN. Revista dels Estudis de Ciències de la Informació i la Comunicació, núm. 18 (gener).

Roemer, R. B.; Borchardt, R. (2012) “From bibliometrics to altmetrics: A changing scholarly landscape”. College & Research Libraries News, vol. 73, núm. 10, p. 596-600.

Cita recomendada

LÓPEZ-BORRULL, Alexandre. 'Altmetrics': estadísticas que nos explican más (¿y mejor?). COMeIN [en línea], febrero 2014, núm. 30. ISSN: 1696-3296. DOI: https://doi.org/10.7238/c.n30.1410