Hace apenas cinco años, escribí un artículo en esta misma revista en el que hablaba de desinformación y elecciones europeas. En aquel momento, parecía que las elecciones habían tenido unos resultados «aceptables» para el statu quo y se concluyó con que se había sabido actuar contra la desinformación de forma adecuada en relación con la activación del Código de Buenas Prácticas contra la Desinformación, al cual debían adherirse las grandes plataformas y redes sociales.

Cinco años después, las empresas que se muestran en la siguiente imagen firman un nuevo acuerdo en el marco de la Conferencia de Seguridad de Múnich celebrada el pasado febrero para luchar contra el uso engañoso de la inteligencia artificial de cara a las elecciones de este 2024. ¿Qué implica y por qué ahora? Esto lo que trataremos de explicar en este artículo.

Empresas firmantes del acuerdo contra el uso engañoso de la inteligencia artificial

Fuente: https://msftnewsnow.com/2024/02/17/deceptive-ai-election-content-in-2024

Elecciones amenazadas

Cinco años después, la aceleración tecnológica amenaza de nuevo los resultados de unas elecciones. Veamos cuáles son las claves que nos han llevado a este momento:

- El año 2024 es un año electoral, sin duda. Cuantitativa y cualitativamente. Aproximadamente la mitad de la población mundial (alrededor de 4.000 millones de personas) votará este año (o ya ha votado, como es el caso de Taiwan), esta cifra representa la mitad de las contiendas de tipo presidencial. Sin embargo, es principalmente la calidad de los países la que da conciencia de su importancia:

- Estados Unidos (5 de noviembre), con una nueva lucha entre Trump y Biden, con mucha más presión tras lo sucedido en el Capitolio el Día de Reyes de 2020.

- Europa (del 6 al 9 de junio), una nueva prueba de fuego para la tensión entre las visiones socialdemócratas y la pujanza de partidos de la derecha radical a nivel europeo.

- Rusia (15 y 17 de marzo), a pesar de que en este caso una vez se rechazó la candidatura de Boris Nadezhdin, único político que criticaba abiertamente la guerra en Ucrania y era crítico con Putin, no hay ni esperanza ni alternativa.

- Cabe añadir, teniendo en cuenta su importancia geopolítica, las elecciones en México, Venezuela, India y Pakistán. Para más información, recomiendo escuchar el pódcast No es el fin del mundo dedicado al año 2024.

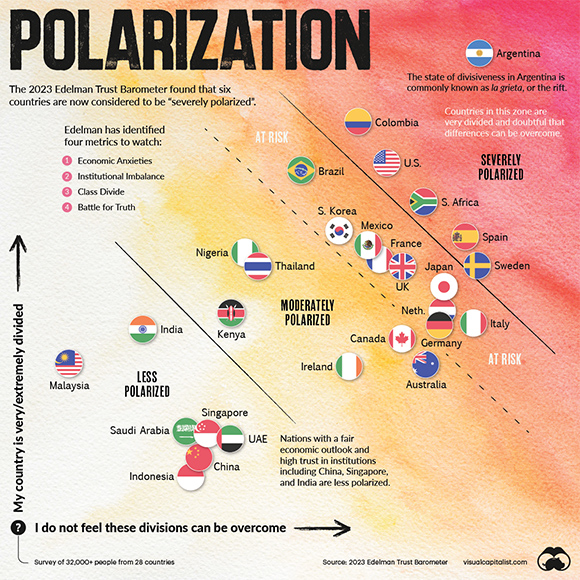

- Tal como explican en Statista, polarización fue la palabra escogida por la Fundéu (RAE) en 2023 por su ingente presencia en los medios de comunicación. Para más información, es muy útil una visualización muy práctica realizada por VisualCapitalist a partir de datos del 2023 Edelman Trust Barometer. Hablamos en términos de polarización política entre dos partes de la sociedad, cada vez más irreconciliables. En algunos casos, ya han pasado procesos electorales, como en Argentina (con un resultado ya conocido); y, en otros casos, ocurrirán este 2024. Una sociedad polarizada es una sociedad como la tierra que no se ha regado ni mantenido, donde cualquier chispa puede generar un incendio social. Y nada causa más chispas sociales que la desinformación y las noticias falsas, a pesar de que, evidentemente, los discursos sociales y políticos de los líderes tienen efecto para inflamar o desinflamar las redes sociales.

Además, añado una nueva brecha, la que se estaría creando entre jóvenes hombres y mujeres, como remachaba últimamente un artículo en el Finantial Times.

La polarización, de un vistazo

Fuente: https://www.visualcapitalist.com/polarization-across-28-countries/#google_vignette

- Como último elemento de la tormenta perfecta que puede suceder este año en relación con la desinformación y las elecciones, cabe añadir –cómo no– la inteligencia artificial (IA), la cual, con su desarrollo rápido y acelerado, está favoreciendo el lado oscuro tecnológico, como ya hemos visto en otras muchas tecnologías. En este caso, las deep fakes, la creación de contenido electoral en que se falsea la voz o la imagen para crear contenidos, que van desde los inofensivos o el activismo, hasta el intento de manipulación. A continuación, veamos unos ejemplos:

- En cuanto a los contenidos inofensivos o incluso humorísticos, podemos encontrar ejemplos como fragmentos de The Shining interpretados por Jim Carrey.

‘The Shining’

Fuente: YouTube

- En cuanto a los activistas, destacaría el que ha hecho la gente de The Lincoln Project (recordamos que Abraham Lincoln fue el primer presidente de los Estados Unidos del Partido Republicano), un comité de acción política prorrepublicano pero contrario a Trump. Tal como dicen, son una organización prodemocracia que trabaja para evitar el retorno de Trump a la Casa Blanca. Para ello, han generado con IA un vídeo muy cuestionable en el que han recreado al padre de Donald Trump (fallecido en 1999), en el que la idea básica es que se avergüenza de él.

- Entre los más preocupantes, señalamos que, a mediados de febrero, se hizo público un vídeo falso donde se decía que el presidente francés Macron había cancelado una visita a Ucrania por la existencia de un complot para asesinarlo. Evidentemente, todo ello tiene repercusiones geopolíticas graves en estos momentos de los conflictos, pero ya ha habido casos de llamadas falsas con voz de Biden llamando a no votar durante las primarias de estos meses. En este caso, fue un llamamiento a la peligrosidad de la tecnología, pero a medida que avance la campaña electoral en los Estados Unidos, irá a más.

Así pues, elecciones, polarización e inteligencia artificial, una mezcla demasiado explosiva que ha llevado a las compañías, promovidas por los gobiernos, a hacer un llamamiento para el control del llamado Deceptive AI Election Content, que como dicen en el propio acuerdo, se trataría de contenidos generados por inteligencia artificial suficientemente convincentes en formado audio, vídeo o imágenes que pueden, consecuentemente, engañar o alterar la apariencia, la voz o las acciones de los políticos candidatos, de los funcionarios electorales u otros grupos de interés clave en unas elecciones democráticas, produciendo información falsa que condicione sobre, cuando, dónde y cómo puede realmente votar. Por lo tanto, se basan en el proceso de las elecciones y se centran en evitar que se inunde de información falsa. Recordamos que conseguir un voto es tan importante para los partidos como las campañas que promueven que los votantes contrarios no vayan a votar. Y todo ello es una amenaza demasiado fuerte.

Acciones recogidas en el acuerdo

Para llevar a cabo lo mencionado, algunas de las acciones recogidas en el acuerdo serán:

- Prevención: investigar, invertir y/o desplegar precauciones razonables para limitar los riesgos de este tipo de contenido electoral engañoso.

- Procedencia: adjuntar señales de procedencia para identificar el origen del contenido cuando sea adecuado y técnicamente factible.

- Detección: tratar de detectar contenido electoral engañoso o contenido autenticado.

- Protección responsiva: proporcionar respuestas rápidas y proporcionadas a las incidencias que impliquen la creación y difusión de contenidos electorales engañosos.

- Evaluación: realizar esfuerzos colectivos para evaluar y aprender de las experiencias y resultados del tratamiento de este tipo de contenido.

- Concienciación pública: participar en esfuerzos compartidos para educar al público sobre las mejores prácticas de alfabetización mediática, en especial, en cuanto a los contenidos electorales engañosos y cómo los ciudadanos se pueden proteger.

- Resiliencia: apoyar a los esfuerzos para desarrollar y poner a disposición herramientas y recursos defensivos, como la alfabetización en IA y otros programas públicos, soluciones basadas en IA (incluyendo herramientas de código abierto, si procede), o contextuales características, para ayudar a proteger el debate público y defender la integridad del proceso democrático.

Habrá que seguir de forma muy atenta todo este acuerdo, y cómo se va concretando, porque mientras el código de buenas prácticas quería luchar contra la desinformación haciendo más transparente la publicidad y las fuentes, en este caso, nos encontramos con la lucha directa contra contenidos difundidos, con la dificultad para poder llevarlo a cabo. Nuevamente, dispondremos de dos herramientas de IA que, como el gato y el ratón, intentarán ser una mejor que las otras para salirse con la suya. Esperemos que no sea una nueva polarización entre tecnologías para ganar su particular contienda electoral. ¿Quién ganará? Lo iremos viendo en nuevos artículos en este mismo espacio.

Para saber más:

3CAT (2024). «Lai Ching-te, el candidat que no volia Pequín, guanya les eleccions a Taiwan». 3cat [en línea]. Disponible en: https://www.ccma.cat/324/lai-ching-te-el-candidat-que-no-volia-pequin-guanya-les-eleccions-a-taiwan/noticia/3270710/

EL ORDEN MUNDIAL (2024). «¿Qué pasará en el mundo en 2024?». No es el fin del mundo, pódcast [en línea]. Disponible en: https://open.spotify.com/episode/4xNacqOGUjVCY7OuzL8xZ

FLORENCIA MELO, María (2024). «Polarización: la palabra de 2023». Statista [en línea]. Disponible en: https://es.statista.com/grafico/31490/palabras-del-ano-elegidas-por-la-fundacion-del-espanol-urgente/

FRANCE 24 (2024). «Presidenciales en Rusia: rechazan la candidatura de Nadezhdin, el único opositor a Putin». France 24 [en línea]. Disponible a: https://www.france24.com/es/europa/20240208-presidenciales-en-rusia-rechazan-la-candidatura-de-nadezhdin-el-único-opositor-a-putin

GALLELLO BONINO, Nacho (2023). «Casi la mitad del mundo vivirá elecciones en 2024: 70 países están llamados a las urnas». Newtral [en línea]. Disponible en: https://www.newtral.es/elecciones-paises-mundo/20231226/

LÓPEZ-BORRULL, Alexandre (2019). «“Fake news” y elecciones europeas, dejamos de mirar el dedo?» COMeIN [en línia], no. 90. ISSN: 1696-3296. DOI: https://doi.org/10.7238/c.n90.1955

RAMER, Holly (2024). «Responsable de llamadas falsas de Biden dice que intentó destacar la necesidad de reglas para la IA». Los Angeles Times [en línea]. Disponible en: https://www.latimes.com/espanol/eeuu/articulo/2024-02-26/responsable-de-llamadas-falsas-de-biden-dice-que-intento-destacar-la-necesidad-de-reglas-para-la-ia

RAO, Pallavi (2023). «Which Countries are the Most Polarized?». Visual capitalist [en línea]. Disponible en: https://www.visualcapitalist.com/polarization-across-28-countries/#google_vignette

Citació recomanada

LÓPEZ-BORRULL, Alexandre. «Polarización, elecciones y ‘deep fakes’: elementos para una tormenta perfecta en un año electoral». COMeIN [en línea], marzo 2024, no. 141. ISSN: 1696-3296. DOI: https://doi.org/10.7238/c.n141.2418